記憶装置間の高速化手法

本記事では、記憶装置間の速度差を埋めて、待ち時間によるロスを防ぐための手法の一つを紹介します。

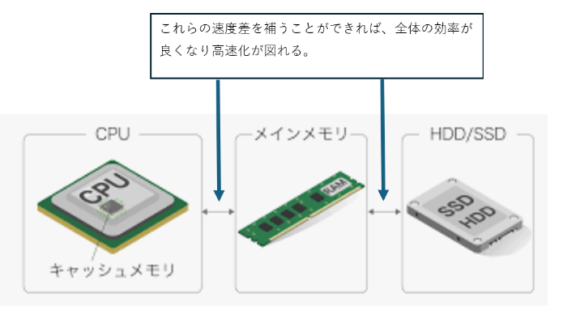

その前に、CPUのレジスタと主記憶装置(メインメモリ)とハードディスク(HDD/SSD)の間では、大きな速度差があります。

この速度差を防ぐための手法がキャッシュになります。

またレジスタとメモリ間に設けるキャッシュメモリ※と、メインメモリとハードディスク(HDD/SSD)の間に設けるディスクキャッシュなどがあります。

※上記の図のようにCPUの中にキャッシュメモリが入っていて、処理の高速化が図られています。

キャッシュメモリとディスクキャッシュ

・キャッシュメモリ

キャッシュメモリは、1次キャッシュ、2次キャッシュ…と、重ねて設置できる装置になります。

CPUに内蔵できる容量はすごく小さいものになるので、「それより低速だけど、その分容量を大きく持てる」メモリをCPUの外側に増設することで、キャッシュ効果が期待できます。

キャッシュ効果:CPUが主記憶装置から読み込んだデータはキャッシュメモリに保持されるので、同じデータを読むときは、高速なキャッシュメモリから取得することができます。これにより処理の高速化が図れます。

DRAMは主記憶装置に使われるので、DRAMより速いSRAMがキャッシュメモリとして使われます。

・ディスクキャッシュ

キャッシュメモリと同じ役割を、主記憶装置とHDD/SSD間で担うのがディスクキャッシュになります。

ディスクキャッシュは、専用の半導体メモリを搭載したり、主記憶装置の一部を間借りするなどして実装します。

以上が高速化の手法の紹介になります。